I supporti digitali non sono eterni: come tramandarli?

June 17, 2018 12:15A novembre scorso sono stato ospite della Biblioteca Delfini di Modena per una conferenza sulla conservazione dei dati digitali. Il video della conferenza è disponibile online:

Buona visione.

Questo articolo vi arriva gratuitamente e senza pubblicità grazie alle donazioni dei lettori. Se vi è piaciuto, potete incoraggiarmi a scrivere ancora facendo una donazione anche voi, tramite Paypal (paypal.me/disinformatico), Bitcoin (3AN7DscEZN1x6CLR57e1fSA1LC3yQ387Pv) o altri metodi.

Perché è così difficile insegnare a un computer a guidare un’auto?

June 15, 2018 6:57“Ma cosa ci vorrà mai”, pensano spesso i non addetti ai lavori quando si parla di programmare un computer per farlo interagire con il mondo reale. In fin dei conti, dicono, se un bambino è capace di riconoscere un oggetto e di allungare una mano e prenderlo, non può essere un compito così difficile insegnare la stessa cosa a una macchina: basta immettere le istruzioni giuste.Non è così, e una bella dimostrazione di quanto sia difficile questa interazione è proposta da Andrej Karpathy, direttore del reparto di intelligenza artificiale di Tesla, in questa conferenza tenuta al TRAIN AI 2018. Il video è qui (l’embed non è permesso; la parte più ghiotta è dal quindicesimo minuto in poi) e le slide della sua presentazione sono qui sotto.

Sottolineo che quello descritto da Karpathy non è il software attualmente installato sulle Tesla, ma è la base di quello che verrà installato in futuro; alcuni suoi elementi sono già inclusi nel software installato a partire da marzo scorso.

L’azienda sta usando le immagini acquisite dalle telecamere di bordo delle proprie auto, circa 250.000 sparse per il mondo, per costruire un enorme archivio sul quale addestrare il proprio software di intelligenza artificiale in modo da permettergli, a furia di vedere esempi, di riconoscere gli oggetti che incontra per strada e gestirli di conseguenza.

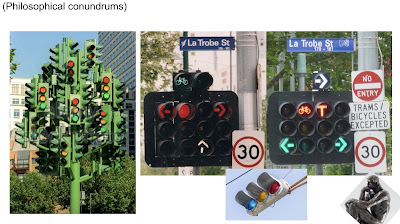

Detta così pare facile: per insegnare a un’auto a riconoscere un semaforo basta farle vedere tanti semafori di vari tipi e il software si farà un’astrazione del concetto di semaforo. Ma Karpathy presenta alcuni esempi eloquenti di quanto possa essere variabile l’idea apparentemente semplice di “semaforo”.

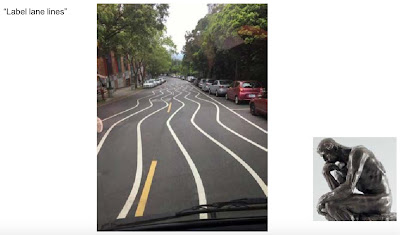

Ci sono anche altri esempi chiarissimi nella presentazione di Andrej Karpathy. Pare abbastanza banale riconoscere le righe di delimitazione di una corsia, ma poi trovi cose come queste:

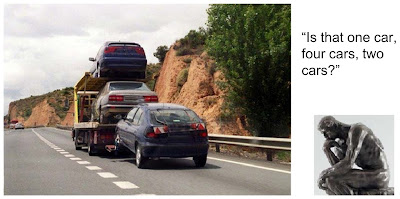

Anche la categoria “automobili” pare abbastanza ovvia da riconoscere, poi capita un caso come questo: quante auto sono? Una sola, due, quattro?

Uno degli aspetti più difficili è includere i casi atipici e rari: la stragrande maggioranza delle immagini campione acquisite e usate per addestrare l’intelligenza artificiale rappresenta auto e solo una piccolissima percentuale mostra altri veicoli insoliti, tipo i tram, oppure situazioni come le strade innevate.

Un caso che sembra comune ma in realtà è raro è il giallo dei semafori: è un segnale importante tanto quanto il verde e il rosso, eppure compare molto meno frequentemente degli altri due colori nelle immagini raccolte. Insegnare al software che un evento raro è importante e va capito bene tanto quanto uno frequentissimo non è banale.

Poi c’è l’incubo della lettura dei cartelli stradali (che mette in crisi anche molti esseri umani).

La parte più difficile, insomma, non è più scrivere le singole righe di istruzioni, ma costruire un repertorio di immagini realmente completo e correttamente bilanciato. Forse non arriveremo alla guida realmente autonoma finché non decideremo di semplificare e uniformare drasticamente la segnaletica e la viabilità, riprogettandola in funzione dei limiti del software di guida.

Lucchetto “smart” annuncia a tutti la propria password

June 15, 2018 3:42Cento dollari per un lucchetto sono una bella cifra, ma quello venduto dalla Tapplock è un lucchetto speciale, perché è “smart”: contiene un processore e un sensore d’impronte digitali e si sblocca appoggiando sul sensore un dito autorizzato. Niente chiavi da perdere, nessuna combinazione da ricordare. C’è anche un’app per gestire fino a 500 impronte. Pratico, no?

Praticissimo, e specialmente per i ladri. I ricercatori della Pen Test Partners hanno scoperto infatti che le promesse di sicurezza del lucchetto erano decisamente fantasiose. Hanno scritto un’app che sblocca qualunque lucchetto smart di questa marca in due secondi.

Come hanno fatto? Hanno comprato uno di questi lucchetti e hanno analizzato il traffico Bluetooth fra il lucchetto e l’app. Per prima cosa si sono accorti che il codice di sblocco che veniva trasmesso era uguale per tutti gli utenti autorizzati di quell’esemplare di lucchetto (che già non è una bella cosa). Ma poi hanno scoperto che il codice di sblocco era derivato dal MAC address del dispositivo.

Un MAC address è l’identificativo univoco che viene assegnato a un singolo esemplare di qualunque oggetto che va connesso a una rete. Viene trasmesso necessariamente in chiaro in ogni pacchetto di dati che viene inviato dal dispositivo, e deve essere ricevibile da qualunque dispositivo in ascolto. Usarlo come base per le password è quindi un’idea stupendamente idiota.

Per fare un paragone, è l’equivalente di usare come password il proprio nome utente.

Eppure TappLock viene venduto dicendo che usa “crittografia AES a 128 bit, la stessa usata dai militari”.

L’azienda ha confermato la vulnerabilità e ha pubblicato un avviso che raccomanda sibillinamente ai propri clienti di aggiornare il firmware dei lucchetti “per avere la protezione più recente”, senza dire che la protezione attuale è un colabrodo.

Come per tanti oggetti dell’Internet delle Cose, a parte la pessima progettazione, il problema è che è molto improbabile che questi avvisi di aggiornamento raggiungano gli utenti e che, se li raggiungono, vengano ascoltati.

Violare un computer con la voce? Con Windows 10 si può

June 15, 2018 3:13Se usate Windows 10, vi conviene aggiornarlo: Microsoft ha rilasciato un aggiornamento correttivo che risolve una cinquantina di vulnerabilité, undici delle quali sono state classificate come “critiche”.La più spettacolare riguarda Cortana, l’assistente vocale integrato in Windows 10, che ha un difetto grazie al quale un aggressore può sbloccare un computer non aggiornato quando è protetto dalla schermata di blocco. Lo sblocco avviene semplicemente dandogli un comando a voce.

La falla, denominata CVE-2018-8140, è utilizzabile per esempio per cambiare la password di accesso a un computer, per accedere ai dati presenti nel computer o per eseguire un malware con pieni privilegi. Dopo che l’utente (o l’aggressore) ha pronunciato la frase di attivazione “Ehi Cortana”, infatti, Windows 10 gli permette di digitare in una casella di ricerca. Questa casella accetta varie parole chiave, come pas (l’inizio di password), e risponde fornendo informazioni che riguardano quello che è stato digitato: per esempio l’ubicazione di un file di password.

In alternativa l’aggressore può fare clic destro per far comparire un menu che include varie opzioni pericolose, come “esegui come Amministratore” oppure “esegui con PowerShell” (la shell di comando testuale di Microsoft).

Su Bleepingcomputer trovate un video di dimostrazione di un attacco che sfrutta questa vulnerabilità vocale. Presso McAfee trovate tutti i dettagli degli altri modi molto creativi nei quali questo attacco può essere messo a segno.

Naturalmente questa falla è sfruttabile soltanto da un aggressore che si trovi fisicamente vicino al vostro computer e libero di agire (e a quel punto la partita è ormai già quasi persa); una situazione che può capitare abbastanza facilmente in ufficio, quando si lascia il PC incustodito perché tanto ci pensa la schermata di blocco a proteggerlo.

Aggiornate il vostro PC, insomma, e se non usate Cortana, disabilitate questo assistente vocale.

Come si riconosce un video Deepfake? A occhio

June 15, 2018 2:40 |

| Sì, è Nicolas Cage nei Predatori dell’Arca Perduta (deepfake). |

L’idea che ci si possa trovare circondati da video falsi indistinguibili dagli originali ha ovviamente delle forti implicazioni in molti campi, dalla politica al giornalismo alla documentazione storica alle indagini giudiziarie. Ma la ricerca scientifica corre veloce anche nel settore dello smascheramento di questi falsi, proponendo tecniche di analisi e identificazione sempre più ingegnose.

Tre ricercatori della State University of New York hanno pubblicato una di queste tecniche nel paper In Ictu Oculi: Exposing AI Generated Fake Face Videos by Detecting Eye Blinking, che suggerisce di esaminare matematicamente il movimento delle palpebre nei video per capire se è naturale o no e quindi rivelare eventuali falsificazioni.

Le persone sbattono le palpebre in media circa 17 volte al minuto: questa cadenza aumenta durante una conversazione e diminuisce durante la lettura. Ma gli attuali software di generazione dei deepfake non tengono conto di questo fenomeno, per cui una cadenza errata, misurata da un apposito software, rivela la manipolazione.

Secondo i ricercatori, fra l’altro, migliorare i deepfake per includere la cadenza corretta non è facile, perché i dataset usati per “addestrare” questi programmi di solito non contengono immagini dei volti-bersaglio con gli occhi chiusi. I falsificatori dovranno quindi inventarsi un modo per aggiungere il movimento corretto delle palpebre. La gara fra falsificatori e smascheratori non conosce soste.